[지디넷코리아]

양자컴퓨터 시대를 대비한 양자내성암호(PQC) 전환이 본격화되면서, NPU(신경망처리장치)가 차세대 보안 인프라의 핵심 요소로 부상하고 있다. NPU가 PQC 연산을 직접 수행하는 것은 아니지만, PQC 도입으로 증가하는 시스템 부담을 흡수하는 역할을 맡으면서 존재감이 커지고 있다는 평가다.

PQC는 기존 암호 체계를 대체하는 차세대 보안 기술로, 양자컴퓨터 환경에서도 안전성을 유지하는 것을 목표로 한다. 그러나 PQC는 대규모 행렬·다항식 연산을 요구해 연산량과 전력 소모가 크게 늘어나게 된다. 이로 인해 인증, 통신, 업데이트 과정에서 CPU 부담이 증가한다. 특히 엣지 디바이스 환경에서는 성능 저하와 지연이 문제로 지적된다.

30일 반도체 업계에서는 PQC로의 전환을 단순한 암호 알고리즘 교체가 아니라 시스템 설계 전반의 문제로 보고 있다. 연산량 증가로 인한 CPU 병목을 어떻게 완화하느냐가 PQC 도입의 현실성을 좌우한다는 분석이다.

PQC를 위한 암호 연산 자체는 여전히 CPU와 HSM(하드웨어 보안 모듈), TPM(하드웨어 기반 보안 칩) 등 보안 영역에서 수행된다. 신뢰 경계와 보안 요구사항 때문이다. NPU가 PQC 연산을 직접 처리하는 구조는 아닌 셈이다.

문제는 PQC 도입으로 인해 CPU에 연산이 집중된다는 점이다. 이를 그대로 둘 경우 시스템 전체의 효율과 안정성이 급격히 떨어질 수 있다. 이 때문에 업계에서는 PQC 전환 과정에서 연산 부하를 분산할 수 있는 구조가 필요하다는 지적이 나온다.

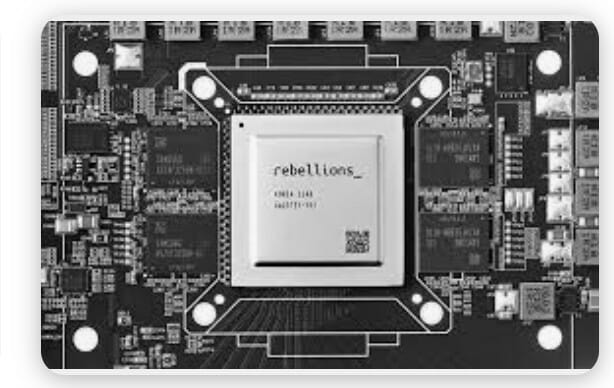

이 과정에서 NPU의 역할이 부각되고 있다. NPU는 AI 추론을 위해 설계된 가속기로, 저지연과 전력 효율이라는 구조적 강점을 갖는다.

김현호 AMD 재팬 연구원은 “NPU의 가치는 단순한 성능 수치보다 저지연과 전력 효율에 있다”며 “PQC처럼 시스템 전반의 연산 부담을 키우는 기술이 도입될수록 이런 특성이 더욱 중요해진다”고 설명했다.

NPU는 AI·데이터 처리 등 기존 CPU 워크로드 일부를 오프로딩함으로써 CPU가 암호 연산에 집중할 수 있는 여유를 만든다. 오프로딩은 CPU 부담을 다른 가속기로 분산하는 구조를 의미한다.

김 연구원은 “NPU가 PQC 연산을 직접 수행하는 것은 아니지만, 그 과정에서 발생하는 유사한 연산 부담을 분산시켜 시스템 차원에서 PQC를 가능하게 한다”고 말했다.

업계에서는 PQC 연산과 NPU 연산이 구조적으로 유사한 점이 많지만 완전히 동일하지는 않다고 보고 있다. 이로 인해 NPU의 역할이 단순화돼 전달되는 경우도 있었지만, 시스템 관점에서 보면 PQC 전환 흐름 속에서 NPU가 자연스럽게 핵심 인프라로 자리 잡고 있다는 분석이 나오는 이유다.

다만 국내 업계에서는 보다 신중한 시각도 제기된다. NPU가 PQC 구현의 중심으로 보기에는 다소 이르다는 의견이다. 오히려 PQC 병목 해결의 현실적인 방법으로 NTT(Number Theoretic Transform) 최적화를 제시했다.

국내 팹리스 ICTK 관계자는 “PQC 성능의 핵심 병목은 여전히 다항식 연산, 특히 NTT 최적화에 있다”며 “현재로서는 CPU와 전용 암호 가속기를 중심으로 성능을 끌어올리는 접근이 가장 현실적”이라고 말했다.

이어 “NPU는 시스템 부하 완화 측면에서 의미가 있지만, PQC 구현의 중심 축으로 보기는 이르다”고 덧붙였다.